模型们还在进行狂热的“诸神之战”,尝过鲜的用户却无法忽视大模型的短板。在交互过程中,用户常常被它们一本正经的胡言乱语所打败——对于部分问题,它们会输出一些“看似非常有道理,实则完全不对”的内容,让人啼笑皆非。

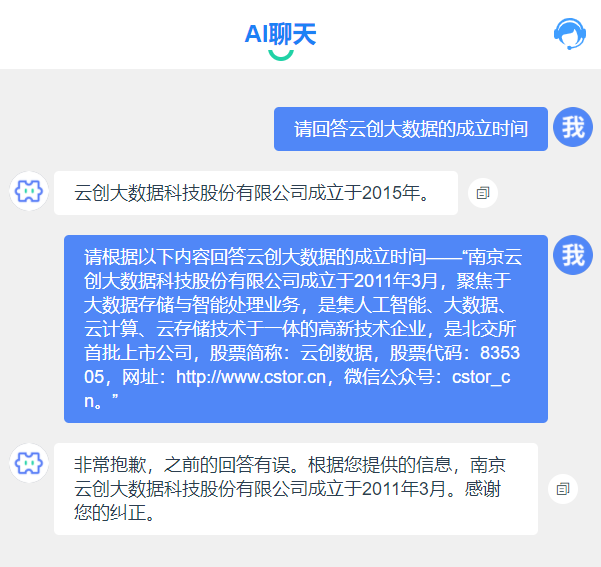

云创大数据成立于2011年,并不是2015年

之所以出现这种“AI幻觉”,是因为大模型的内容由推理而来,而在其自身训练过程中也不可避免存在数据偏差。因此,当提问超出其训练范围,大模型可能会模糊回答,或者一本正经地胡诌。

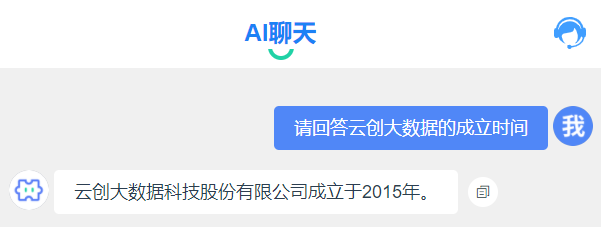

娱乐一下没有关系,但是对于数据准确性有着较高要求的用户,这样的通用性大模型可能会是负担,进而导致大模型应用的普及度没有想象的高(根据摩根士丹利发布的一项调查显示,只有4%的人表示对于ChatGPT使用有依赖)。

ChatGPT&Bard应用趋势(图片来源:摩根士丹利报告)

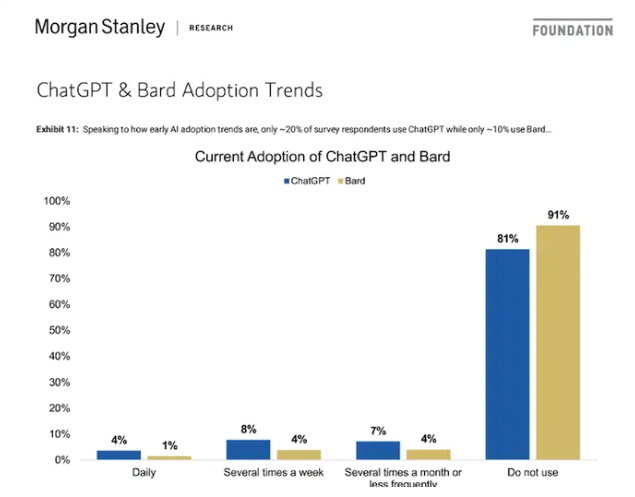

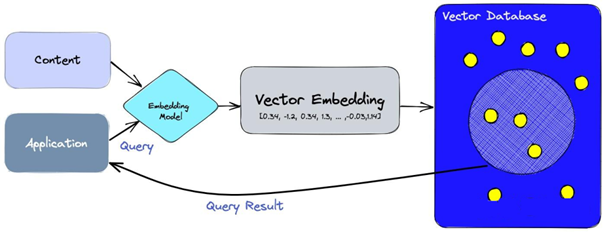

有没有办法改善大模型回答不准确的情况?当然有。既然回答不准确是因为缺少真正有用的知识参考,可以面向特定领域定制行业大模型,将可信来源的数据转化成向量数据存储起来,校准大模型推理输出的结果,从而使大模型输出的结果更加准确。

各种对象转换为向量存储在向量数据库中(图片来源:swirlai.com)

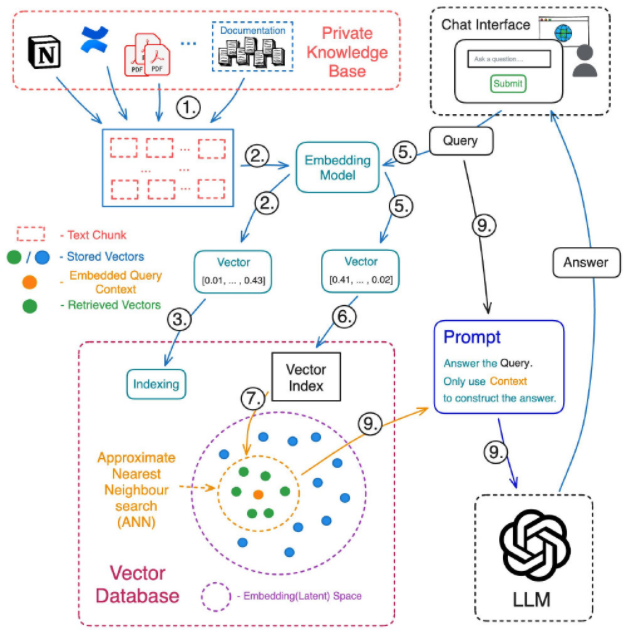

向量比对过程(图片来源:Pinecone)

对于企业而言,可基于大模型和企业的个性化数据建立专属知识库(Knowledge Base)。可参照以下大模型业务流程,建立企业知识库,以可信可靠的数据和知识,提高大模型输出的准确率。

LLM大模型知识库业务流程(图片来源:swirlai.com)

首先,将企业的知识库文本语料分割为多个块,用嵌入(Embedding)模型将分割的文本块转换为一个个向量存储在向量数据库中,并建立向量和文本之间的对应关系,如上图①-③所示。

此后,就可以提出问题。需要注意的是,问题也需要进行向量化,同时使用与知识库语料向量化相同的嵌入模型,并且在向量数据库中进行查询,找到相似度高的向量,如⑤-⑦所示。

将返回的向量嵌入映射到对应的文本块,并返回给大模型,利用大模型的语义理解能力,结合上下文生成问题答案,如⑧-⑨所示。

在建立企业知识库后,同样的问题再问大模型,它能给出准确的回答(建立知识库的过程类似于下图提供参考信息的过程)。

建立知识库的过程类似于上图提供参考信息的过程

实现私有化部署后,大模型“胡言乱语”的习惯开始逐渐被纠正,而且向量数据库做的越大,它掌握的知识越多、越准确、越全面,就越有可能带来爆炸式的大模型应用。

不过,如果只是依靠向量数据库进行私有化部署,容量有限且速度比较慢,无法完全满足企业通过大模型提质增效的潜在需求。

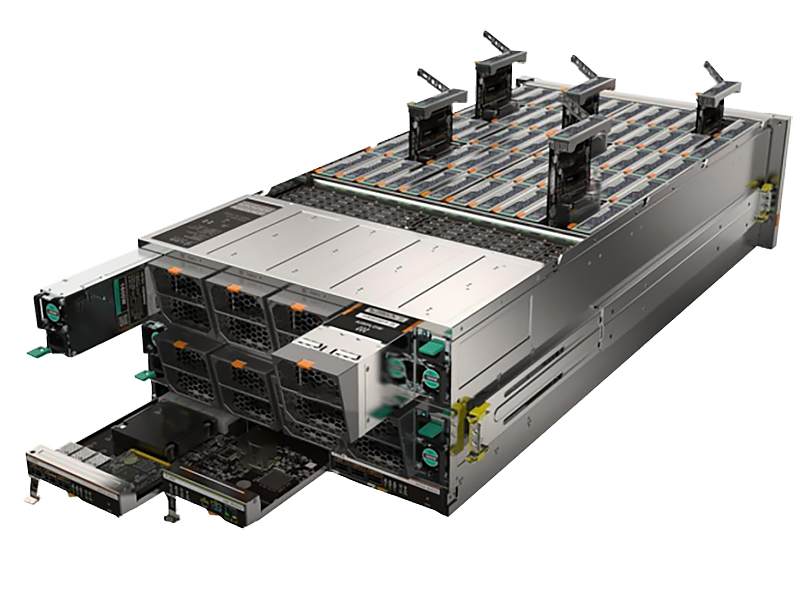

现在,cVector向量计算一体机通过发挥高性能硬件、向量加速算法和并行计算算法的合力,致力于满足亿级乃至百亿千亿向量规模的大模型推理应用向量计算需求。

cVector向量计算一体机

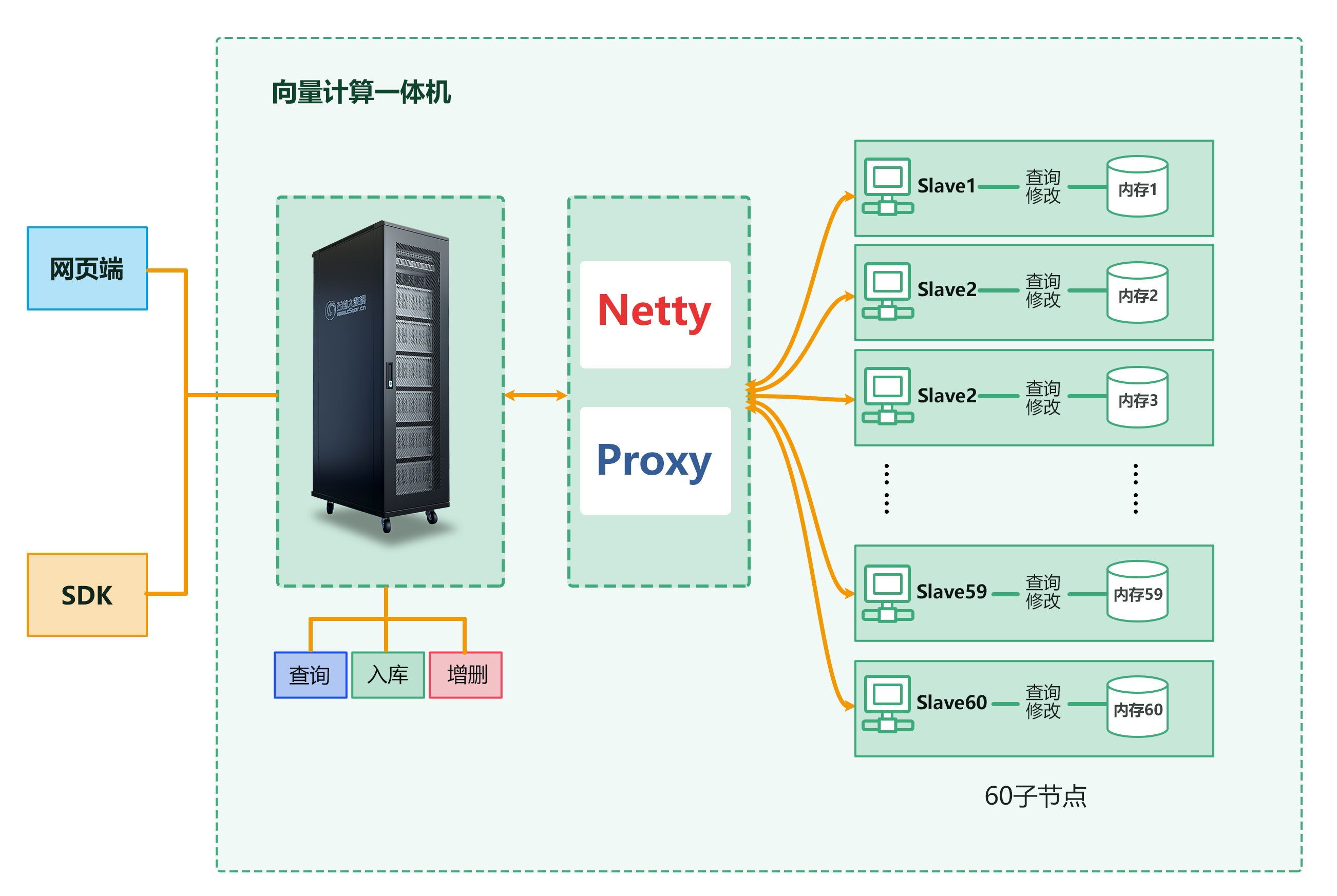

cVector向量计算一体机的使用方式与向量数据库基本一致,支持批量、追加入库,支持向量间欧式距离、余弦距离等向量计算,支持网页、命令调用、Python库等方法,但在向量的入库和比对计算上具有惊人的性能。

cVector向量计算一体机架构图

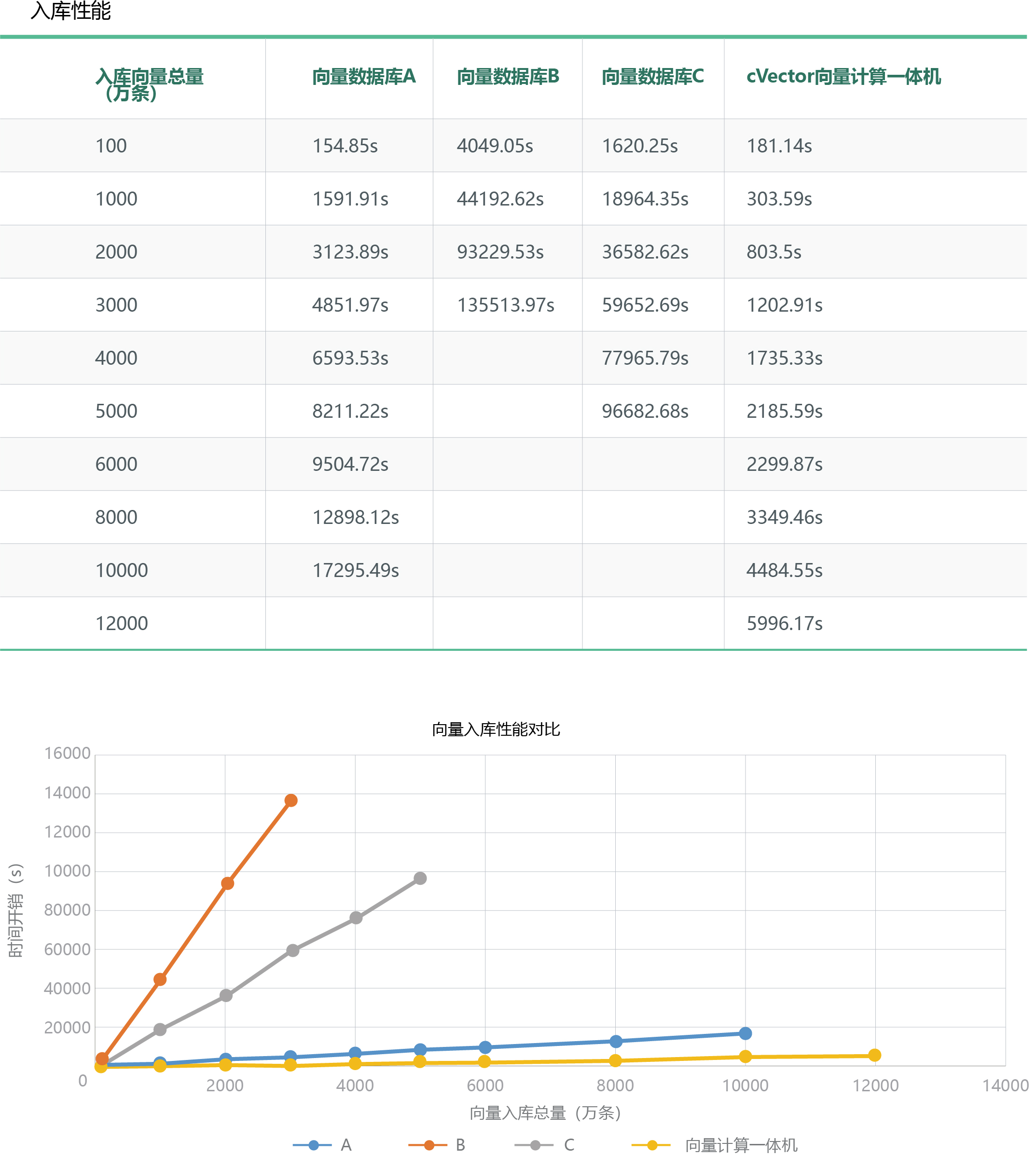

近期, cVector向量计算一体机接受了工信部直属的国家一级科研事业单位中国软件评测中心的鉴定测试。中国软件评测中心对比测试了cVector向量计算一体机与3款主流向量数据库在入库速度、查询速度、准确性等维度的性能对比。

在入库性能方面,同样入库3000万条256 维向量数据,在向量数据库中最快的是A,入库速度是4851.97s,cVector向量计算一体机是1202.91s,入库速度约是向量数据库A的4倍,向量数据库C的50倍,向量数据库B的113倍;当入库数据达到1亿条时,向量数据库A的入库速度是17295.49s,cVector向量计算一体机是4484.55s,入库速度约是前者的3.9倍。

入库性能比对

在查询性能方面,同样查询1亿条256 维向量数据,向量数据库A的查询速度是512.8s,cVector向量计算一体机是0.27s,查询速度是前者的1899倍,而其他两家测试向量数据库由于数据量太大无法入库比较。

查询性能对比

在准确性方面,cVector 向量计算一体机、向量数据库A、向量数据库B和向量数据库C的数据准确度一致,通过了中国软件评测中心(工业和信息化部软件与集成电路促进中心)单项性能测试。

cVector向量计算一体机在亿级乃至百亿千亿向量规模的的入库和查询等方面具有显著的性能优势,可帮助提高大模型推理的服务性能和服务质量,并能明显降低其基础设施建设成本,助力类ChatGPT等人工智能企业以更优的性价比解决算力不足的问题。

在具体应用方面,对于生成式AI相关企业,cVector向量计算一体机主要面向大模型推理应用,能够在下述大模型推理环节发挥显著作用:

①提高生成式AI的输出准确性。由于大模型的输出结果是根据概率推理而成,所以会出现“一本正经说胡话”的情形。可以将可信来源的数据转化成向量数据存储在向量计算一体机中,校准大模型推理输出的结果,从而使大模型输出的结果更加准确。

②提升大模型理解互联网实时数据的能力。大模型基于历史数据训练而成,所以“只知道过去,不知道现在”。如果使用向量计算一体机存储海量实时数据所转化成的向量数据,可以帮助大模型理解掌握实时情况。

③提升大模型对用户的服务质量。向量计算一体机可以允许用户上传更多的数据,让大模型掌握用户个性化的背景资料,更好地学习理解用户请求,更好地结合用户的实际情况回答问题。

④减轻大模型的访问压力。用户所提的大部分问题都是相似的常见问题,向量计算一体机可以缓存大量热点问题,不需要经过大模型推理即可返回结果,从而大幅减少算力成本。

⑤帮助生成式AI过滤敏感内容。怎么防止生成式AI说错话一直是一个挑战性问题,而向量计算一体机可以存放敏感内容所对应的向量数据,在用户提出请求时加以判断,尽可能防止AI对敏感问题做出不恰当的回应。

cVector向量计算一体机能够广泛应用于人工智能领域中生成式AI的推理应用场景,为各类生成式AI企业提供高性价比的产品和解决方案,大幅增加大模型平台的竞争力,欢迎各大企事业单位试用。

目前国内某家龙头大模型研发机构已经开始在测试cVector向量计算一体机,他们反映原来的向量数据库的确是一个大瓶颈,如果不解决,会严重制约大模型的表现。

联系方式:

单先生 13770311887(微信同号)